Audit SEO ↓

Résumé en bref :

Un audit SEO permet d’analyser la santé de votre site en matière de référencement naturel. Il inclut des vérifications techniques, éditoriales, sémantiques et de popularité pour améliorer votre visibilité.

Faire appel à un consultant SEO freelance garantit une expertise adaptée à vos besoins, avec des outils comme Screaming Frog ou Semrush.

Les résultats attendus incluent plus de trafic, des conversions améliorées, et une meilleure visibilité. Les tarifs commencent à 800 euros.

Qu’est-ce qu’un audit SEO ?

Un audit SEO est un état des lieux complet de la santé de votre site web en termes de référencement naturel. Il permet d’analyser les différents aspects techniques, sémantiques, éditoriaux et de popularité d’un site pour en améliorer le positionnement sur les moteurs de recherche.

L’objectif est d’identifier les points faibles et les axes d’amélioration pour maximiser la visibilité et le trafic organique.

Pourquoi contacter un freelance pour un audit SEO ?

Un consultant freelance réalise des audits régulièrement et a l’habitude de travailler sur divers types de sites. Grâce à son expérience, il saura apporter des solutions adaptées à votre projet.

De plus, il maîtrise des outils spécifiques qui sont indispensables pour un audit de qualité, tels que :

- Screaming Frog pour l’audit technique

- Semrush pour l’étude des mots-clés

- Majestic SEO pour l’analyse de netlinking

- Thot SEO pour la sémantique

Il dispose aussi de nombreux processus et templates qui permettent de ressortir rapidement les pistes d’amélioration et de les prioriser efficacement.

Les étapes de mon audit SEO

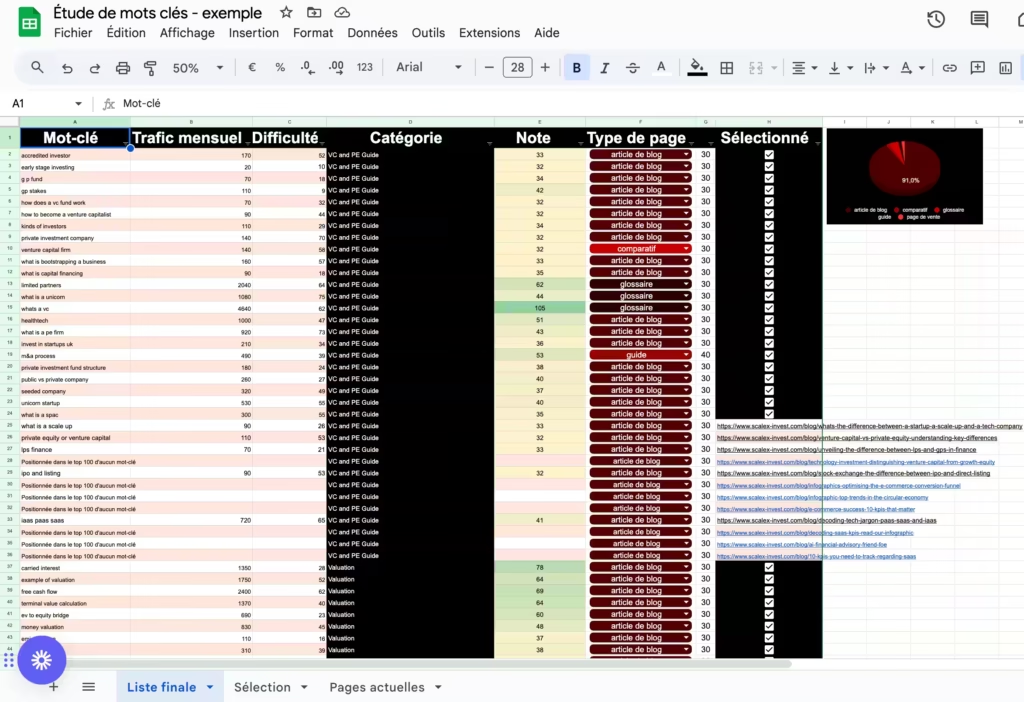

1. Analyse sémantique

L’objectif est d’analyser les mots-clés déjà positionnés, le trafic actuel, et de rechercher de nouveaux mots-clés pertinents pour mieux cibler vos prospects.

Cela inclut également une analyse approfondie des mots-clés des concurrents afin d’identifier des opportunités de positionnement non exploitées.

En fonction de ces données, je vous aide à ajuster votre stratégie de contenu pour capter plus de trafic qualifié.

2. Audit éditorial

Je vérifie la qualité de vos contenus SEO, la pertinence de la sémantique utilisée et les balises SEO (titres, descriptions).

Je m’assure aussi que vos contenus répondent précisément à l’intention de recherche des utilisateurs, et j’analyse le SXO (Search Experience Optimization) pour optimiser l’expérience utilisateur.

Chaque contenu doit à la fois être bien rédigé et répondre aux critères techniques de référencement.

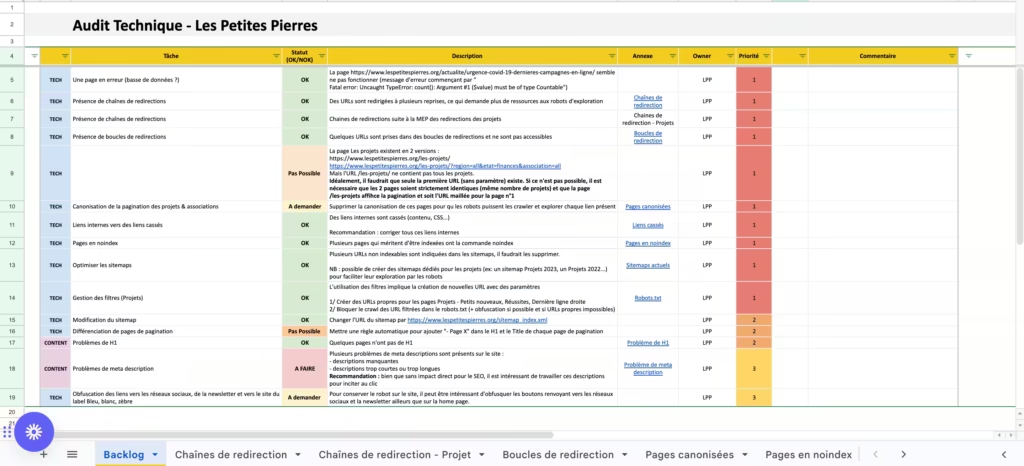

3. Audit technique

Je détecte les problèmes techniques affectant la crawlabilité, l’indexabilité, la vitesse de chargement, et le maillage interne de votre site.

Nous vérifions également la sécurité, le responsive, et l’utilisation des données structurées pour garantir une meilleure indexation.

Tous ces éléments sont cruciaux pour assurer une bonne visibilité dans les résultats de recherche, en optimisant l’accessibilité de votre site pour les moteurs.

4. Audit de popularité

Cet audit analyse le netlinking (les backlinks) et les signaux EEAT (Expertise, Authoritativeness, Trustworthiness).

Je vérifie la qualité de vos liens entrants et leur pertinence, ainsi que la réputation de votre site auprès des moteurs de recherche.

Un bon profil de liens est un gage de crédibilité et joue un rôle important dans votre positionnement sur Google.

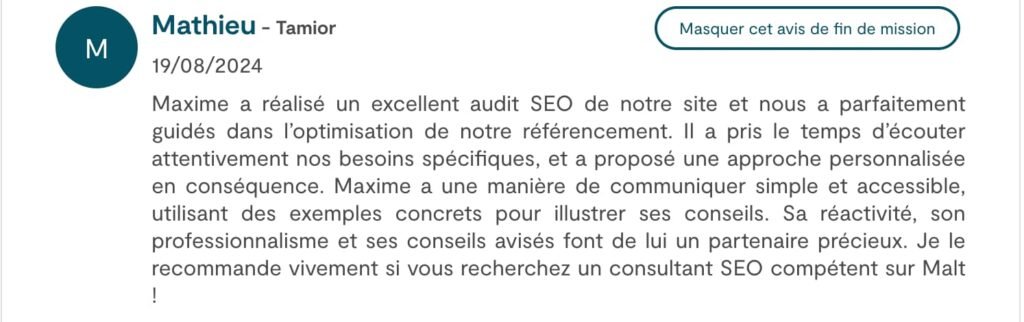

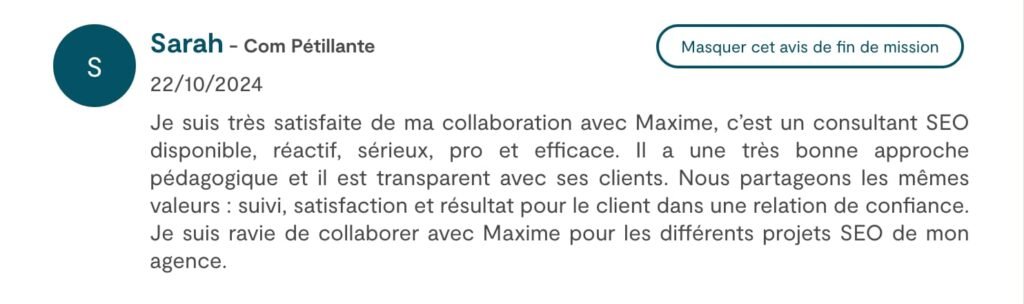

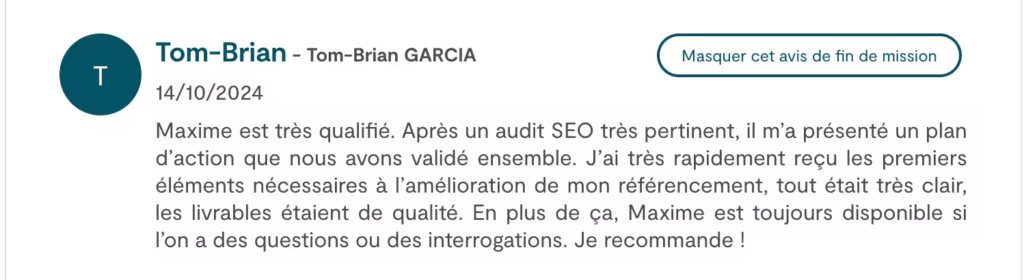

Avis clients sur mes audits SEO

Tarifs d’un audit SEO réalisé par un freelance

Mes prestations d’audits commencent à 800 euros pour un site vitrine de petite taille (2 jours d’audit) et peuvent atteindre 2800 euros pour des sites plus complexes (7 jours d’audit).

Le tarif est basé sur mon TJM de 400 euros et dépend de la taille, des enjeux, et de la complexité du site. Chaque audit est personnalisé et adapté aux besoins spécifiques de votre site, pour vous garantir des résultats optimaux.

Quels résultats concrets attendre d’un audit SEO ?

Un audit SEO bien réalisé peut entraîner plusieurs résultats concrets :

- Plus de trafic organique

- Plus de conversions grâce à une meilleure optimisation

- Amélioration de la vitesse de chargement

- Augmentation des ventes en améliorant la visibilité du site

Comment bien intégrer les recommandations SEO faites dans l’audit ?

Pour intégrer correctement les recommandations d’un audit SEO, voici les étapes à suivre :

- Prévoyez de consacrer du temps pour les implémenter.

- Si les changements sont importants, faites appel à un développeur pour les aspects techniques.

- Vous pouvez aussi vous faire accompagner par un consultant SEO qui vous guidera dans l’application des recommandations de manière précise et efficace.

Si l’audit SEO ne correspond pas à 100 % à vos besoins, sachez que je propose également des coachings SEO.